导读 NVIDIAGPU已经在AI、HPC领域遥遥领先,但没有最强,只有更强。现在,NVIDIA又发布了全新的HGXH200加速器,可处理AIGC、HPC工作负载的海量数...

NVIDIAGPU已经在AI、HPC领域遥遥领先,但没有最强,只有更强。

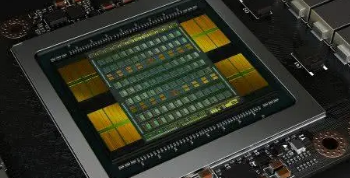

现在,NVIDIA又发布了全新的HGXH200加速器,可处理AIGC、HPC工作负载的海量数据。

NVIDIAH200的一大特点就是首发新一代HBM3e高带宽内存(疑似来自SK海力士),单颗容量就多达141GB(原始容量144GB但为提高良率屏蔽了一点点),同时带宽多达4.8TB/s。

对比H100,容量增加了76%,带宽增加了43%,而对比上代A100,更是容量几乎翻番,带宽增加2.4倍。

得益于NVLink、NVSwitch高速互连技术,H200还可以四路、八路并联,因此单系统的HBM3e内存容量能做到最多1128GB,也就是1.1TB。

只是相比于AMDInstinctMI300X还差点意思,后者搭载了192GBHBM3,带宽高达5.2TB/s。

性能方面,H200再一次实现了飞跃,700亿参数的Llama2大语言模型推理性能比H100提高了多达90%,1750亿参数的GTP-3模型推理性能也提高了60%,而对比前代A100HPC模拟性能直接翻番。

八路H200系统下,FP8深度学习计算性能可以超过32PFlops,也就是每秒3.2亿亿次浮点计算,堪比一台大型超级计算机。

随着未来软件的持续升级,H200还有望继续释放潜力,实现更大的性能优势。

此外,H200还可以与采用超高速NVLink-C2C互连技术的NVIDIAGraceCPU处理器搭配使用,就组成了GH200GraceHopper超级芯片,专为大型HPC、AI应用而设计的计算模块。

NVIDIAH200将从2024年第二季度开始通过全球系统制造商、云服务提供商提供。